Chatbot, woher bekommst du eigentlich deine Daten?

Vor kurzem habe ich über Google berichtet. Laut einer neuen Datenschutzerklärung, die am 1. Juli 2023 in Kraft trat, behält sich der Technologiekonzern das Recht vor, alle im Internet gefundenen Daten für das Training seiner KI-Systeme zu verwenden. Doch Google ist nicht das einzige Unternehmen, das Daten aus dem Internet zieht. Zahlreiche Firmen setzen sogenannte Crawler ein, um das Web systematisch und automatisiert zu durchsuchen und Daten für verschiedene Zwecke zu sammeln und zu analysieren – sei es für Suchmaschinen oder für KI-Modelle.

In einem nun veröffentlichten Dokumentationseintrag verweist OpenAI auf einen eigenen Crawler (GPTBot), der das Web durchsucht und Daten sammelt:

„Web pages crawled with the GPTBot user agent may potentially be used to improve future models and are filtered to remove sources that require paywall access, are known to gather personally identifiable information (PII), or have text that violates our policies.“

Diese Aussage gibt einen gewissen Einblick in die mögliche Datenbasis der zukünftigen Sprachmodelle von OpenAI. Zum einen könnte dies die Verarbeitung aktueller Daten betreffen, die in den GPT-Modellen noch nicht enthalten sind. So antwortet GPT-4 (Version vom 03.08.2023) auf die Frage „Wer ist der Bundeskanzler von Deutschland?“: „Bis zu meinem letzten Trainingsdatensatz im September 2021 war Angela Merkel die Bundeskanzlerin von Deutschland. [...]“ Besser macht es der Bing Chatbot, der ebenfalls mit GPT-4 arbeitet, aber von Microsoft mit Daten aus dem Bing Crawler gefüttert wird und entsprechend auf aktuelle Ereignisse reagieren kann. Hier könnte OpenAI mit einem eigenen Crawler nachziehen.

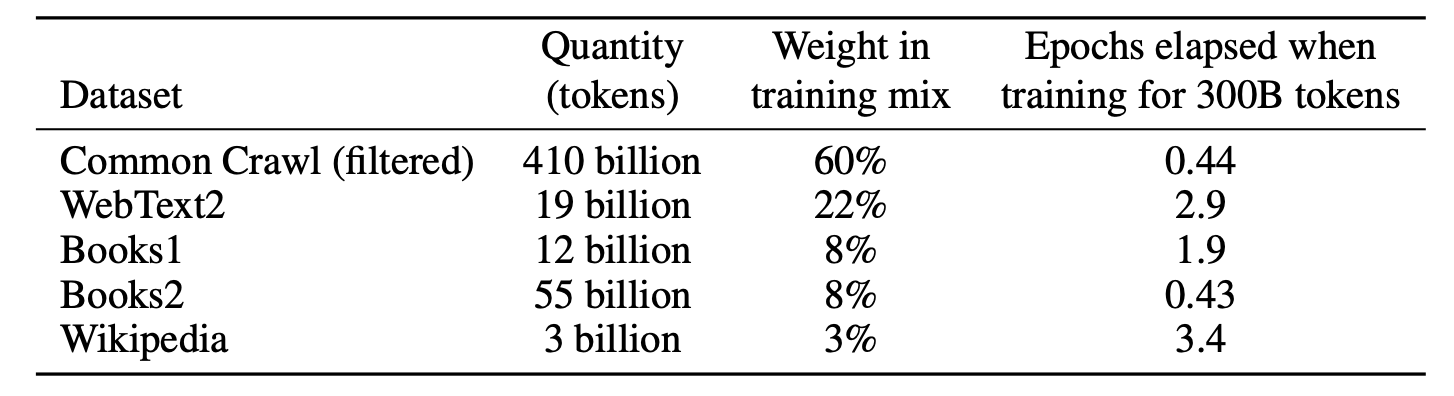

Auf der anderen Seite wird es spannend sein, zu sehen, wie sich die Datensätze der zukünftigen Basismodelle zusammensetzen werden. Die aktuellen großen Sprachmodelle, deren Datenbasis wir kennen, basieren beispielsweise auf dem Common Crawl Datensatz. Der Datensatz der Non-Profit-Organisation Common Crawl ist eine öffentlich zugängliche Sammlung von Webseitendaten, die regelmäßig durch Crawlen des Internets aktualisiert wird. Dieser Datensatz wird dann in der Regel von den Firmen, die ein Sprachmodell erstellen, vor dem Training gefiltert und dient zusammen mit anderen Daten als Grundlage für das Training des Sprachmodells. Für das Modell GPT-3 stammen beispielsweise 60 % des Trainingsdatensatzes von Common Crawl (siehe Abbildung). Für GPT-4 und andere Modelle wie Googles PaLM 2 oder Metas Llama 2 wurden solche genauen Informationen bisher nicht veröffentlicht.

Auch wenn zunehmend intransparenter wird, mit welchen Daten die KI-Modelle trainiert wurden, geben sich

die Unternehmen bei der Verwendung der Daten der eigenen Nutzer:innen noch zurückhaltend. Google etwa

spricht in seiner geänderten Datenschutzerklärung

von öffentlichen

Quellen

. Und Meta gibt sich in

seinem Llama 2 Paper zwar schmallippig, was die zum

Training

verwendeten Daten betrifft, schreibt aber: Neither the

pretraining nor the fine-tuning datasets include Meta user data

. OpenAI klärte in einem am 21.

Juli aktualisierten Artikel auf:

„Inputs and outputs to our API (directly via API call or via Playground) for model inference do not become part of our models. Specifically:

- We make our models available through our API after they finish training.

- Models deployed to the API are statically versioned: they are not retrained or updated in real-time with API requests.

- Your API inputs and outputs do not become part of the training data unless you explicitly opt in.“

Interessanterweise gilt dies nicht für Daten, die in der ChatGPT-App verarbeitet werden: Sources of data for training our models may include (1)

data submitted through our first party ChatGPT web or iOS app (unless individual users turn off chat

history)

.

Trotz der einen oder anderen Information über die Quellen und die Art der verwendeten Daten bleibt die genaue Art und Herkunft der Daten, die für das Training der Sprachmodelle verwendet werden, häufig im Dunkeln. Es fällt auf, dass die Unternehmen bei der Entwicklung ihrer Technologien in letzter Zeit weniger transparent zu sein scheinen als in den Jahren zuvor. Als Pionier der Transformer-Technologie, die modernen Sprachmodellen zugrunde liegt, hat Google in der Vergangenheit viele seiner Forschungsergebnisse veröffentlicht. Allerdings zeigt sich das Unternehmen heute deutlich zurückhaltender, wenn es darum geht, Forschungsergebnisse zu veröffentlichen. Auch Meta gab bei der Veröffentlichung von Lama 1 im Februar 2023 noch detaillierte Informationen über die verwendeten Daten. Nur wenige Monate später, im Juli 2023, bei dem von Meta selbst als „open source“ bezeichneten Modell Lama 2, fehlten solche Informationen jedoch auffällig. Doch in Anbetracht des disruptiven Potenzials, das die derzeitige Entwicklung im Bereich der Künstlichen Intelligenz mit sich bringt, reicht es nicht aus, lediglich zu versichern, dass die Daten der Nutzer:innen geschützt sind. Notwendig ist eine umfassende Transparenz und Rechenschaftspflicht darüber, welche Daten tatsächlich gesammelt und wie sie verwendet werden. Die aktuelle Situation zeigt, dass die Zusagen der Technologieunternehmen gegenüber den Verbraucher:innen oft nicht ausreichen. Und Datentransparenz ist auch nicht Teil der jüngsten Zusicherungen, die Risiken von KI zu mindern. Es ist dringend erforderlich, dass Unternehmen ihre Praktiken in Bezug auf die Transparenz von Daten, die für das Training von KI verwendet werden, überdenken.